来自纽约大学、Evidation Health 和 NYU Langone Health 的一组研究人员发现,深度学习心电图设备容易受到对抗性攻击。在他们发表在《自然医学》杂志上的论文中,该小组描述了他们如何开发一种攻击方法并用心电图设备对其进行测试。

在过去几年中,人们发现深度学习系统非常擅长某些对人类具有挑战性的任务,例如下棋或在人群中寻找面孔。深度学习系统也已应用于医学——例如帮助检测乳腺癌肿瘤或监测生命体征例如心跳,以提醒医生或患者注意问题。其中一个应用是心电图采集系统,其中一个设备监测心脏并分析心电图——一个人的心跳记录。已经开发和训练了深度学习算法来寻找可能表明不规则心房颤动等活动的异常情况。智能手表等设备就是为使用它们而设计的。在这项新的努力中,研究人员发现了此类设备及其产生的输出容易受到攻击的证据。

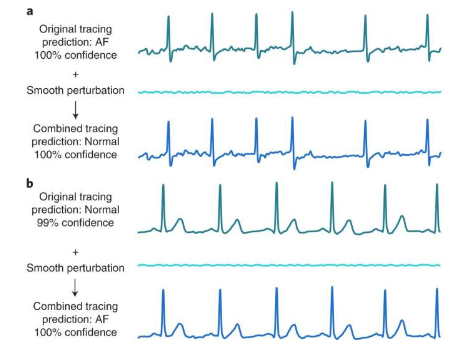

研究人员通过首先获得一组数千个心电图记录来证明深度学习心电图设备的一个漏洞,他们将这些记录分为四组之一:正常组、显示心房颤动的组、其他组或噪声组。在拆分数据并在自己的卷积网络上训练他们的系统后,他们向测试集中的样本引入了少量噪声——太小以至于人类无法分辨,但足以让人工智能系统认为它看到的是心房纤颤。测试表明它按计划工作。系统错误地将正常的心电图识别为心房颤动的例子在 74% 的测试图表中。研究人员还向两名临床医生展示了对抗样本——他们没有那么容易被愚弄。他们只发现 1.4% 的读数贴错了标签。

研究人员承认,黑客很难用智能手机等真实心电图设备的数据复制他们的努力,因为这需要直接访问——这在现实世界中不太可能实现。但是,他们仍然表示,他们的努力表明,基于人工智能的医疗设备在被批准供公众使用之前应该进行漏洞测试。

标签:

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!