罗切斯特大学德尔蒙特神经科学研究所的研究人员扩大了对复杂视听语音感知过程中大脑如何参与的理解。

现在发表在NeuroImage上的这项研究描述了聆听和观看叙述者讲述故事如何激活大脑区域的广泛网络,这些区域涉及与理解故事内容相关的感觉处理、多感觉整合和认知功能。了解这个更大网络的参与有可能为研究人员提供研究神经发育障碍的新方法。

“多感官整合是我们神经系统的一项重要功能,因为它可以显着增强我们检测和识别环境中物体的能力,”影像科学和神经科学研究助理教授、该研究的第一作者 Lars Ross 博士说。学习。“这种功能的失败可能会导致感觉环境被认为是压倒性的,并可能导致一个人难以适应周围环境,我们认为这是一些神经发育障碍(如自闭症)症状的基础。”

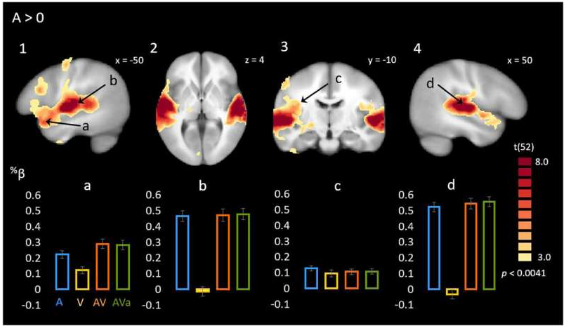

研究人员使用 fMRI 检查了 53 名参与者的大脑活动,他们观看了朗读“The Lorax”的演讲者的录像。故事的呈现方式将以四种方式之一随机变化——仅音频、仅视觉、同步视听或不同步视听。

研究人员还监测了参与者的眼球运动。他们发现,除了先前确定的多感觉整合位点外,观察说话者的面部动作还增强了更广泛的语义网络和通常与多感觉整合无关的语言外区域的大脑活动,例如杏仁核和初级视觉皮层。研究人员还发现丘脑区域的活动,众所周知,这些区域是我们眼睛和耳朵的感觉信息相互作用的早期阶段。

“这表明除了多感官整合之外的许多区域在大脑如何处理复杂的多感官语音中发挥作用 - 包括那些与语言外感知和认知处理相关的区域,”罗斯说。

据研究人员称,研究人员在设计这个实验时考虑到了儿童,他们已经开始与自闭症谱系的儿童和成人一起工作,以深入了解他们处理视听语音的能力如何随着时间的推移而发展。

标签:

免责声明:本文由用户上传,与本网站立场无关。财经信息仅供读者参考,并不构成投资建议。投资者据此操作,风险自担。 如有侵权请联系删除!